Menschwerden

DISKURS

„Kein Sexroboter kann ‚nein‘ sagen“

Nach welchen Regeln sollen Menschen und Roboter zusammenleben? Philosophin Janina Loh über Maschinenethik und die immer innigere Beziehung zu intelligenten Geräten.

Nach welchen Regeln sollen Menschen und Roboter zusammenleben? Philosophin Janina Loh über Maschinenethik und die immer innigere Beziehung zu intelligenten Geräten.

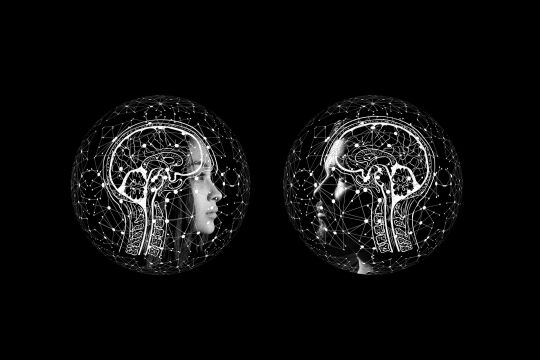

Sind Roboter autonom? Können sie gar moralisch handeln? Haben sie einen moralischen Wert? Sollten ihnen Rechte zuerkannt werden? Wer ist zur Rechenschaft zu ziehen, wenn ein Roboter einen Menschen schädigt? Diese und weitere ethische Fragen werden von Janina Loh kritisch verhandelt. Im September erscheint im Suhrkamp-Verlag ihre Einführung in die Roboterethik. Die Philosophin arbeitet an der Universität Wien zu den Schwerpunkten Maschinenethik und Posthumanismus. Die FURCHE hat nachgefragt.

DIE FURCHE: Frau Loh, was versteht man eigentlich unter Roboterethik?

Janina Loh: Sie beschäftigt sich mit den moralischen Kriterien beim Bau von Robotern und im Umgang mit ihnen. Einerseits muss etwa ein Pflegeroboter bestimmten Regeln folgen, darf sich beispielsweise nicht gegen seine Besitzer auflehnen. Auf der anderen Seite müssen die Besitzer den Roboter auch personalisieren können. Das Robotersystem muss in einem minimalen Rahmen einstellbar sein, um sich an seinen Besitzer anpassen zu können. Welche Werte gesetzt werden und wie ein guter Umgang mit Robotern aussieht, muss man sich vorab überlegen.

DIE FURCHE: Der Science Fiction-Autor Isaac Asimov hat bereits 1942 „Robotergesetze“ formuliert, die garantieren sollen, dass Roboter den Menschen keinen Schaden zufügen. Sind diese noch brauchbar für eine aktuelle Roboterethik?

Loh: Die „Robotergesetze“ von Asimov sind sehr abstrakt und können je nach Kontext sogar widersprüchlich sein. Gesetze brauchen immer eine bestimmte Interpretation. Wir Menschen gelangen auch in Dilemma-Situationen – im Gegensatz zu Robotern können wir aber in so einem Fall von unseren Regeln abweichen. Solange Roboter nicht lernfähig sind, haben sie dann vermutlich nur die Möglichkeit, in den Standby-Modus zu gehen.

DIE FURCHE: Wie helfen ethische Grundsätze dabei, auftretende Konflikte zu lösen?

Loh: Roboter sind heute in allen Bereichen zu finden, von der Pflege über das Militär bis hin zu Sexrobotern. Als Produkte menschlichen Handelns haben sie automatisch Werte implementiert, weil menschliches Handeln durch Werte gesteuert wird. Ja, alle Technologien haben bewusst oder unbewusst Werte implementiert. So muss beispielsweise ein Maschinengewehr Schaden zufügen. Wenn wir Maschinen konstruieren, die mit Menschen interagieren, dann müssen diese mit den „richtigen“ Werten ausgestattet sein. Ein autonomes Auto muss in einer Konfliktsituation entscheiden können, ob es zum Beispiel den Abhang hinunterfährt, die drei Ärzte bei ihrer Mittagspause wegrammt oder ob es sich anderweitig verhält. Das ist eine ethische Entscheidung, und eine solche muss bereits im Vorfeld implementiert werden.

DIE FURCHE: Bevor Dynamit als Terrorinstrument missbraucht wurde, bekam es aber wohl auch andere Werte implementiert ...

Loh: Produkte können immer für andere Zwecke instrumentalisiert werden. Mit einem Maschinengewehr kann man ja theoretisch auch einen Nagel in die Wand schlagen. Es gibt aber immer einen oder mehrere primäre Werte, über die Nebenfolgen muss man sich im Klaren sein. Das Problem beim Implementieren von Werten ist, dass es Menschen sind, die dies tun. Ich nehme immer das Beispiel Sexroboter: Diese wurden nach problematischen Gender-Stereotypen entwickelt. Als Konsument kann ich entscheiden, nach welchen diskriminierenden Stereotypen der Roboter funktionieren soll. In allen Bereichen dieser Welt brauchen wir heterogene Gruppen von Menschen, die zusammen entscheiden – so auch bei Sexrobotern. Man stelle sich eine Ethikkommission für technologische Produkte vor, die nur aus weißen, heterosexuellen Männern über 50 Jahren besteht.

DIE FURCHE: Trägt allein der Mensch die Verantwortung gegenüber den Robotern, oder können auch Roboter selbst für ihr Handeln verantwortlich sein?

Loh: Bis auf weiteres sind es nur die Menschen: aber nicht nur die Designer und Firmen, die Technologien verkaufen, sondern auch alle Menschen, die damit umgehen. Verantwortung kann man verteilen und jeder Mensch hat unterschiedliche Verantwortlichkeiten. Denkt man diese Systeme weiter, könnten smarte und autonome Roboter künftig vielleicht auch Verantwortung übernehmen. Bis jetzt kenne ich aber keinen Roboter, der das kann.

DIE FURCHE: Wann wird das der Fall sein?

Loh: Wenn man etwa dem schwedischen Philosophen Nick Bostrom Glauben schenkt, wird es einmal eine künstliche Superintelligenz geben. Das ist aber kein Naturgesetz, das liegt allein in unserer Hand. Im Militär, in der Medizin und in der Pflege haben wir momentan Maschinen, die nach bestimmten Regeln funktionieren, also „Inselbegabungen“ haben. Ein Schachcomputer kann zum Beispiel super Schach spielen, wird aber nie in den Krieg ziehen. In Bereichen, wo Menschen zu Schaden kommen könnten, sind lernfähige Systeme ethisch unerwünscht. Denn lernen bedeutet immer auch, Fehler zu machen. Sollten wir künftig einmal selbstlernende, autonome Autos haben, müssen wir uns gut überlegen, welche Werte man diesen implementiert. Ebenso, ob wir smarte Super-Roboter überhaupt wollen und in welchen Bereichen diese eingesetzt werden sollten.

DIE FURCHE: Kann es sein, dass sich Maschinen mit Künstlicher Intelligenz der menschlichen Kontrolle entziehen?

Loh: Bislang sind alle Maschinen, die auf dem Markt verfügbar sind, bis auf weiteres „Moral Patients“, also Objekte moralischen Handelns. Sie können nicht selbstständig handeln, weil Lernfähigkeit nötig und nur ein geringes Abweichen von der algorithmischen Grundstruktur möglich ist, die man implementiert hat. „Moral Agents“ gibt es im Hinblick auf Roboter bis jetzt nicht, höchstens im rudimentären Sinn. Vielleicht aber werden wir bei Robotern künftig dieselben Rechte und Pflichten einführen wie bei Menschen. Denn je lernfähiger Maschinen werden, desto weniger Kontrolle haben wir über sie. Dasselbe gilt bei Kindern: Man würde ja auch nicht sagen, dass Kinder volle moralische Personen sind. Sie sind moralische Personen im Werden. Wir können versuchen, unsere Kinder nach unseren Werten zu erziehen, aber wenn die Kinder dann nicht so werden, wie die Eltern sich das vorgestellt haben, kann man auch nichts dagegen tun. Am Ende ist es das Unverfügbare im Menschen, das eine absolute Kontrolle nicht möglich macht – genauso bei lernfähigen Maschinen. Wenn wir irgendwann künstliche moralische Akteure schaffen, dann verlieren wir die absolute Kontrolle über sie.

Ein Thema. Viele Standpunkte. Im FURCHE-Navigator weiterlesen.

In Kürze startet hier der FURCHE-Navigator.

Steigen Sie ein in die Diskurse der Vergangenheit und entdecken Sie das Wesentliche für die Gegenwart. Zu jedem Artikel finden Sie weitere Beiträge, die den Blickwinkel inhaltlich erweitern und historisch vertiefen. Dafür digitalisieren wir die FURCHE zurück bis zum Gründungsjahr 1945 - wir beginnen mit dem gesamten Content der letzten 20 Jahre Entdecken Sie hier in Kürze Texte von FURCHE-Autorinnen und -Autoren wie Friedrich Heer, Thomas Bernhard, Hilde Spiel, Kardinal König, Hubert Feichtlbauer, Elfriede Jelinek oder Josef Hader!

.png)