True News

FOKUS

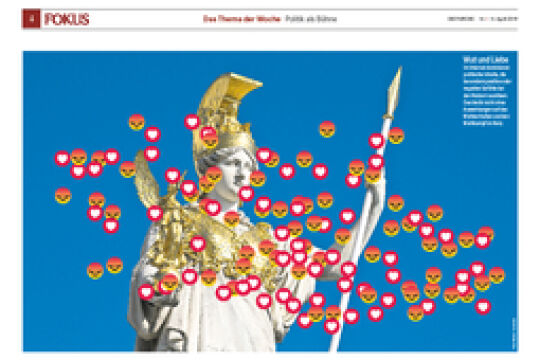

Soziale Medien: Raus aus der Blase

Soziale Medien treiben im Eiltempo die Spaltung der Gesellschaft voran. Doch jetzt regt sich Widerstand: Wie sich Journalisten, Forscher und Tech-Firmen gemeinsam gegen Fake News und verzerrte Weltbilder wehren.

Soziale Medien treiben im Eiltempo die Spaltung der Gesellschaft voran. Doch jetzt regt sich Widerstand: Wie sich Journalisten, Forscher und Tech-Firmen gemeinsam gegen Fake News und verzerrte Weltbilder wehren.

Tabea Wilke sitzt bei der Internetkonferenz „Re:Publika“ am Diskussionspodium und spricht über Wahlmanipulation. Die Frau mit den braunen Haaren und dem schwarzen Blazer ist eine der gefragtesten Expertinnen im deutschsprachigen Raum, wenn es um Manipulation im Netz geht. 2017 gründete sie das Berliner Start-up „Botswatch“, dessen Geschäftsführerin sie seither ist. Das Unternehmen hat sich auf gefälschte, automatisierte Profile in sozialen Medien spezialisiert. Die Idee: Botswatch spürt diese erfundenen Identitäten auf und entlarvt sie quasi in Echtzeit. Grundsätzlich müsse man davon ausgehen, dass keine Wahl vor Manipulationen geschützt sei, erklärte Wilke bei der Re:Publika im Mai dieses Jahres: „Wir müssen immer auf alles vorbereitet sein, auch auf das, was wir uns jetzt noch nicht vorstellen können.“

Wilke und ihr Team arbeiten daran, dass große Trollfabriken, also organisierte Gruppen, die vor Wahlen oder anderen Volksentscheidungen gezielt Falschmeldungen in sozialen Medien verstreuen, weniger Einfluss bekommen. Und damit ist Botswatch nicht alleine. Längst formiert sich Widerstand gegen die Spaltung der Gesellschaft, die nicht zuletzt dem steigenden Einfluss sozialer Medien in politischen Diskursen geschuldet ist. Die neuen Start-up-Gründer möchten Manipulatoren mit ihren eigenen Waffen schlagen. Sie entwickeln Technologien, die verzerrten Meinungsbildern und einseitigen Algorithmen etwas entgegensetzen. Aber ist das tatsächlich der Weg aus der Krise? „Zum Glück sind sich immer mehr Technologie-Unternehmer dessen bewusst, dass Daten im Allgemeinen verzerrt sind und man datenbasierte Algorithmen nicht naiv einsetzen darf“, sagt Stefan Szeider, Informatiker und Professor an der Technischen Universität Wien.

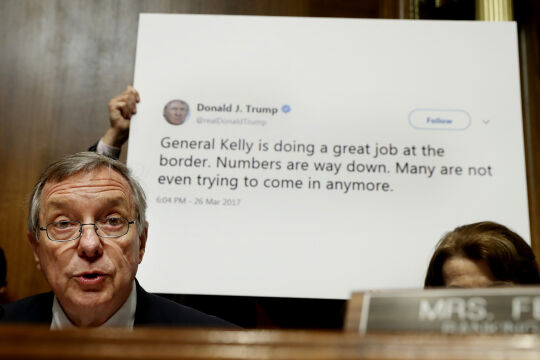

Denn spätestens seit dem Brexit-Referendum, dem irischen Abtreibungs-Referendum oder der US-Wahl werden über soziale Medien beachtliche Kampagnen gefahren. Mithilfe automatisierter Programme, sogenannten „Social Bots“, können Falschmeldungen und provokante Aussagen zum Beispiel auf Twitter beliebig häufig geteilt und verbreitet werden. Botswatch möchte diese Programme in Echtzeit scannen, erkennen und transparent machen. So ließe sich herausfinden, ob hinter der verbreiteten Botschaft tatsächlich eine echte Person steckt oder ein automatisiertes Programm, das gezielt zur Manipulation eingesetzt wird. Dafür werden ununterbrochen Daten analysiert und ausgewertet, immer auf der Suche nach Unregelmäßigkeiten.

Intransparente Systeme

Dennoch: 2018 erntete das Start-up auch Kritik. So hatte Botswatch einen Diskurs über den damals verabschiedeten UN-Migrationspakt auf Twitter gescannt und behauptet, dass 28 Prozent der gesendeten Tweets über den Migrationspakt von Social Bots stammen. Die Analyse sorgte für Aufsehen. Doch Experten kritisieren, dass Botswatch die Methode, wie die knapp 800.000 Tweets, die zum Migrationspakt ausgewertet wurden, nicht offenlegt. Das Unternehmen argumentierte damit, dass es den Kern seines Geschäftsmodells nicht verraten werde und man das Geschäftsgeheimnis akzeptieren müsse. Botswatch ist nur eines von vielen Startups, das sich auf die Enttarnung manipulativer Aktionen im Netz spezialisiert hat. Auch der spanisch-chilenische Informatiker Ricardo Baeza-Yates sorgt mit seiner Firma NTENT im Silicon Valley für Aufmerksamkeit. Baeza-Yates widmet seine Arbeit intelligenten Suchalgorithmen.

Der frühere Vizepräsident der Forschungsabteilung des Internetriesen Yahoo entwickelte seine Idee während des amerikanischen Präsidentschaftswahlkampfs. Mit seinen Suchalgorithmen will er Filter-Blasen ausgleichen. Sobald man im Internet also zu suchen beginnt, greift der Algorithmus ein. Und zwar genau dann, wenn eine Verzerrung der Meinungsbildung droht. Bekommt ein Internetnutzer zum Beispiel nur negative Nachrichten über geflüchtete Menschen, weil er diese immer häufiger anklickt, gleicht der Algorithmus von Baeza-Yates die Suchergebnisse mit neutralerer Berichterstattung wieder aus. „Sowohl wir, die Userinnen und User, als auch künstliche neuronale Netzwerke, die unsere Informationen filtern, müssen lernen, das Entstehen von Verzerrungen und Filter-Bubbles besser zu verstehen“, sagte Baeza-Yates 2017 bei einer Konferenz in Wien. Aber können wir dem mächtigen Algorithmus wirklich auf die Schliche kommen?

Ein Thema. Viele Standpunkte. Im FURCHE-Navigator weiterlesen.

In Kürze startet hier der FURCHE-Navigator.

Steigen Sie ein in die Diskurse der Vergangenheit und entdecken Sie das Wesentliche für die Gegenwart. Zu jedem Artikel finden Sie weitere Beiträge, die den Blickwinkel inhaltlich erweitern und historisch vertiefen. Dafür digitalisieren wir die FURCHE zurück bis zum Gründungsjahr 1945 - wir beginnen mit dem gesamten Content der letzten 20 Jahre Entdecken Sie hier in Kürze Texte von FURCHE-Autorinnen und -Autoren wie Friedrich Heer, Thomas Bernhard, Hilde Spiel, Kardinal König, Hubert Feichtlbauer, Elfriede Jelinek oder Josef Hader!