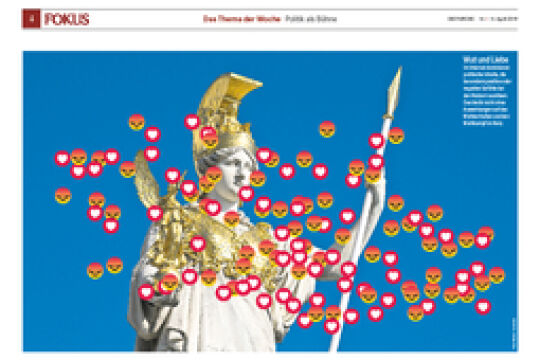

Facebook-Algorithmen: Sind Zwiebeln obszön?

Facebook löscht millionenfach Fotos, weil sie gegen die selbst definierten Gemeinschaftsstandards verstoßen. Über die Realitätsblindheit von Algorithmen.

Facebook löscht millionenfach Fotos, weil sie gegen die selbst definierten Gemeinschaftsstandards verstoßen. Über die Realitätsblindheit von Algorithmen.

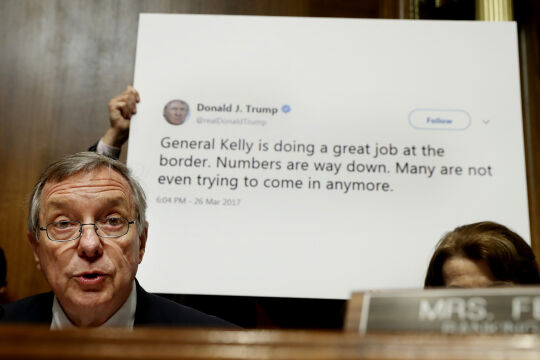

Vor ein paar Wochen lud der Fotograf Mike Hall einige Fotos auf der Facebook-Seite der Northwall Gallery im englischen Winchester hoch. Ein Vorgang, wie er täglich millionenfach vorkommt. Das soziale Netzwerk entfernte diese Bilder aber. So wurde ein Foto mit dem Neonschriftzug „DISCO“ geblockt, weil es angeblich den Verkauf von Alkohol bewerbe. Die Skyline von Hongkong wurde mit der Begründung abgelehnt, dass hier nichts zum Verkauf stehe. Und weidende Kühe hielt der prüde Facebook-Algorithmus für sexuell anstößig. Der Fotograf legte Widerspruch gegen die Entscheidung an. Mit Erfolg: Ein Facebook-Sprecher erklärte, es handele sich bei der Sperre um einen Fehler. Das Unternehmen bedauere den Vorfall. Facebook setzt bei der Moderation von Inhalten – wie andere Plattformen auch – auf eine Mischung aus menschlicher und künstlicher Intelligenz. Während Algorithmen in einem ersten Schritt den groben Abfall trennen, muss eine Armada von Vertragsarbeitern den Restmüll sortieren: Suizide, Sodomie, Massaker. Der digitale Putztrupp, der irgendwo in den USA oder auf den Philippinen auf Bildschirme starrt, muss unter ärgsten psychischen Belastungen entscheiden, ob ein Post gewaltverherrlichend ist oder nicht. Dafür haben sie nicht einmal 30 Sekunden Zeit. Es sind Menschen, die wie Maschinen operieren.

Fatale Botschaften

Um Abgrenzungsprobleme erst gar nicht entstehen zu lassen, hat Facebook den Algorithmus scharf gestellt. So wurden laut einem Bericht des Guardian zwischen Januar und März 2020 allein wegen Nacktheit oder „sexueller Aktivität“ 39,5 Millionen Posts gelöscht, 99,2 Prozent davon automatisch durch Algorithmen. Im Schlund des Datenkraken verschwindet so jede Menge Material, ohne dass davon jemand groß Notiz nimmt. „Es ist viel einfacher, ein KI-System zu bauen, das einen Nippel erkennt, als zu bestimmen, was Hate-Speech linguistisch bedeutetet“, hat Facebook-Chef Mark Zuckerberg einmal gesagt. Damit sprach er aus, was Fachleute längst wissen. Doch die automatischen Filtersysteme haben selbst bei der vermeintlich leichteren Klassifikation von Objekten noch immer Probleme.

Ein Thema. Viele Standpunkte. Im FURCHE-Navigator weiterlesen.

In Kürze startet hier der FURCHE-Navigator.

Steigen Sie ein in die Diskurse der Vergangenheit und entdecken Sie das Wesentliche für die Gegenwart. Zu jedem Artikel finden Sie weitere Beiträge, die den Blickwinkel inhaltlich erweitern und historisch vertiefen. Dafür digitalisieren wir die FURCHE zurück bis zum Gründungsjahr 1945 - wir beginnen mit dem gesamten Content der letzten 20 Jahre Entdecken Sie hier in Kürze Texte von FURCHE-Autorinnen und -Autoren wie Friedrich Heer, Thomas Bernhard, Hilde Spiel, Kardinal König, Hubert Feichtlbauer, Elfriede Jelinek oder Josef Hader!